Un viaje a través de los principales dilemas, desafíos y responsabilidades de la ética de la Inteligencia Artificial. En el vasto y complejo laberinto de la ética de la inteligencia artificial, nos encontramos en un momento crucial. Los avances en IA prometen transformar casi todos los aspectos de nuestras vidas, desde las interacciones cotidianas hasta las decisiones de gran importancia.

Pero con este gran potencial también vienen profundos desafíos éticos. Desde preocupaciones sobre privacidad y sesgo algorítmico hasta la amenaza existencial de una posible superinteligencia, el auge de la IA nos obliga a confrontar algunas de las preguntas más fundamentales sobre tecnología, sociedad y la propia naturaleza de la humanidad.

En este artículo, exploraremos las múltiples dimensiones de la ética de la IA, examinaremos los riesgos y las promesas de esta tecnología transformadora, y consideraremos cómo podemos navegar hacia un futuro centrado en lo humano. ¿Qué desafíos éticos tiene la IA?

El camino por delante no es fácil, pero con cuidado, consideración y un compromiso inquebrantable con nuestros valores más profundos, podemos emerger en un mañana más brillante. ¿Estás listo para embarcar en esta crucial exploración? Comencemos.

Tabla de Contenidos

El Despertar de las Máquinas

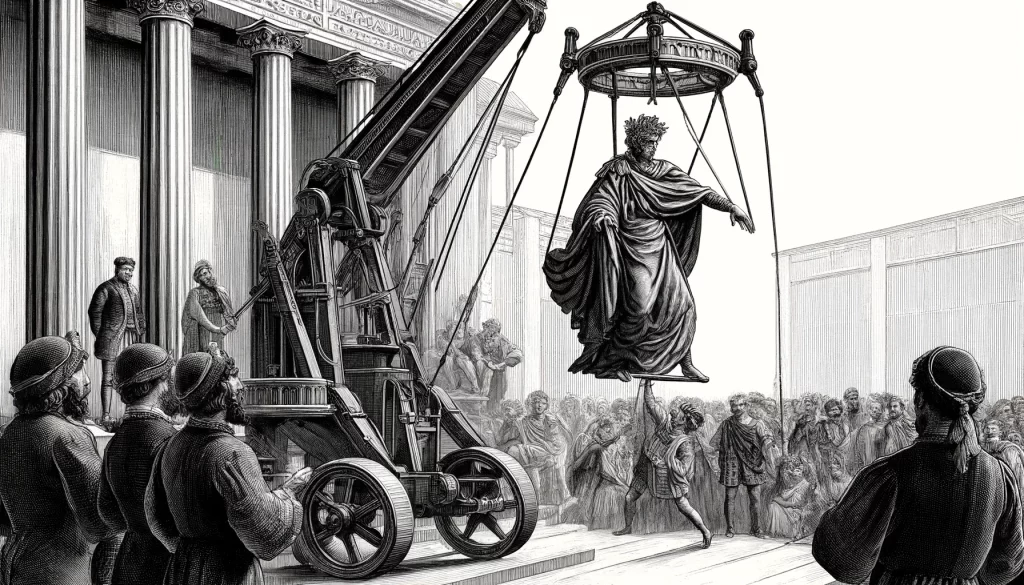

En la antigua tradición del teatro griego, existía un recurso dramático conocido como «Deus ex Machina«. Literalmente «dios desde la máquina», se refería a la práctica de introducir una deidad mediante una grúa para resolver una trama aparentemente irresoluble. El dios, con su poder divino, descendía de los cielos para poner orden en el caos de los asuntos mortales.

Hoy, nos encontramos en un escenario no muy diferente, aunque con un giro singularmente moderno. Se nos intenta vender el uso de la inteligencia artificial como una suerte de «Deus Ex Machina» capaz de venir a poner orden en nuestro mundo.

No obstante las máquinas han despertado, no como dioses literarios, sino como algo quizás mucho más poderoso: algoritmos inteligentes que permean cada aspecto de nuestras vidas. Desde las decisiones más triviales hasta las más trascendentales, estos algoritmos omniscientes parecen tener una influencia casi divina en nuestro mundo.

Y, a diferencia de los benevolentes dioses del teatro, las intenciones detrás de estos algoritmos no siempre son claras. Y a medida que cedemos más poder a la IA, surgen preguntas profundas y desconcertantes: ¿Estamos creando deidades digitales para que gobiernen nuestras vidas? ¿Qué significa para nuestra autonomía que los algoritmos pueden influir en nuestras decisiones sin que lo sepamos? ¿Y qué pasa si estos sistemas, impulsados por lógica fría y datos implacables, toman decisiones que van en contra de nuestros valores más preciados?

En el corazón de estas preguntas yace un reto ético de proporciones épicas. Como Prometeo, hemos creado algo potencialmente más poderoso que nosotros mismos, y ahora debemos lidiar con las consecuencias. Pero quizás aún no sea demasiado tarde. Soy de los optimistas que cree que, armados con sabiduría y previsión, aún podemos forjar un futuro donde la IA sirva a los intereses de la humanidad, en lugar de eclipsarlos.

Este es el desafío que enfrentamos ahora, en la aurora de la era de la IA. Un tiempo en el que los «dioses desde las máquinas» no son meros recursos teatrales, sino realidades tangibles con el poder de moldear nuestro destino y resolver la trama. Cómo naveguemos esta nueva realidad determinará el curso no solo de nuestras vidas, sino potencialmente de nuestra misma existencia como especie.

Quizás el dios en la máquina si que ha despertado. Ahora nos toca a nosotros decidir qué papel queremos que juegue en nuestra historia.

La IA como nueva fuerza en nuestro mundo

Mientras la imagen popular de la IA a menudo evoca visiones de robots humanoides o superinteligencias sin cuerpo, la realidad de su influencia en nuestras vidas es a la vez mucho más mundana y más profunda. Lejos de ser una tecnología del futuro, la IA ya está entretejida en la trama de nuestra existencia diaria, a menudo de maneras que pasan desapercibidas para el ojo no entrenado.

Consideremos, por ejemplo, el humilde acto de pedir un taxi. Hace apenas una década, esto habría implicado llamar a una centralita, donde un operador humano emparejaría manualmente a los pasajeros con los conductores disponibles. Hoy, gigantes como Uber y Lyft han revolucionado esta interacción, reemplazando al intermediario humano con algoritmos de Inteligencia Artificial.

Estos algoritmos no solo determinan qué conductor es asignado a qué pasajero, sino también calculan dinámicamente los precios basándose en la oferta y la demanda en tiempo real, optimizan las rutas basándose en las condiciones de tráfico, e incluso predicen dónde es probable que surja la demanda en función de los patrones históricos. En esencia, cada vez que solicitas un viaje, estás poniendo tu confianza en una IA para que tome decisiones en tu nombre. Y técnicamente, los conductores están siguiendo las órdenes de una IA.

Pero la influencia de la IA se extiende mucho más allá del reino del transporte. Desde los sistemas de recomendación que sugieren qué películas ver en Netflix hasta los algoritmos que deciden qué anuncios ves en las redes sociales, la IA está constantemente moldeando nuestras experiencias en línea. Incluso en el mundo físico, las IA están tomando decisiones con impactos tangibles en las vidas humanas, desde los sistemas de calificación crediticia que determinan las tasas de interés hasta los algoritmos de contratación que filtran los currículums.

En el ámbito de la salud, las IA están siendo utilizadas para detectar cáncer en las mamografías, predecir brotes de enfermedades infecciosas, optimizar procesos en centros clínicos e incluso desarrollar nuevos fármacos. En el sector financiero, los algoritmos de trading de alta frecuencia ejecutan millones de transacciones por segundo, influyendo en los mercados globales en una escala inimaginable para los operadores humanos.

Lo que estos ejemplos ilustran es que la IA ya no es una tecnología emergente o un prospecto futuro, sino una fuerza transformadora que está remodelando activamente nuestro mundo en el presente. Su influencia se extiende a prácticamente todos los aspectos de nuestras vidas, desde las interacciones más triviales hasta las decisiones más consecuentes.

Pero quizás lo más profundo de esta revolución es que a menudo ocurre fuera de nuestra vista. A diferencia de las tecnologías transformadoras del pasado, como la electricidad o el automóvil, la IA no siempre tiene una presencia física obvia. Opera detrás de escena, en el reino digital de los bits y los bytes, incluso cuando sus impactos se sienten profundamente en el mundo físico.

En este sentido, la IA representa un nuevo tipo de fuerza en nuestro mundo: una que es a la vez invisible y omnipresente, intangible pero increíblemente poderosa. A medida que continúa evolucionando y expandiéndose, transformará cada vez más la trama de nuestras vidas, a menudo de maneras que apenas comenzamos a comprender.

Y es precisamente debido a esta naturaleza oculta que es tan crucial que empecemos a examinar seriamente las implicaciones éticas de la IA. Porque en un mundo cada vez más gobernado por algoritmos, las preguntas de equidad, transparencia, responsabilidad y alineación de valores ya no son abstractas, sino que tienen consecuencias reales y apremiantes para individuos y sociedades por igual.

Los Dilemas del Nuevo Olimpo Digital: Ética de la Inteligencia Artificial

1. El Ojo Omnisciente: Privacidad en la Era de la IA

En la mitología griega, los dioses del Olimpo eran conocidos por su capacidad de observar los asuntos de los mortales, a menudo sin su conocimiento o consentimiento. Hoy, en la era de la IA, nos enfrentamos a un fenómeno inquietantemente similar: el ojo de los algoritmos que constantemente recopilan, analizan y actúan sobre nuestros datos personales.

En muchos sentidos, la privacidad es la primera línea de defensa en la batalla por la ética de la IA. Es el derecho más fundamental que está siendo desafiado por el avance de esta tecnología. Con cada clic, cada búsqueda, cada interacción en línea, estamos alimentando un vasto ecosistema de recopilación y análisis de datos, a menudo sin una comprensión clara de cómo se utilizará esa información o quién tendrá acceso a ella.

Las implicaciones de esta recopilación de datos a escala masiva son profundas y de largo alcance. Por un lado, permite niveles de personalización y conveniencia sin precedentes. Los algoritmos pueden anticipar nuestras necesidades, hacer recomendaciones adaptadas a nuestras preferencias e incluso automatizar tareas rutinarias. Pero este beneficio tiene un costo significativo.

Cada punto de datos que generamos contribuye a un perfil digital cada vez más detallado de quiénes somos: nuestros hábitos, nuestros intereses, nuestras relaciones, nuestras vulnerabilidades. Y a medida que la IA se vuelve más avanzada, su capacidad de extraer información de estos perfiles solo se vuelve más poderosa.

Técnicas como el aprendizaje automático y el procesamiento del lenguaje natural permiten a los algoritmos leer entre líneas de nuestros datos, inferir nuestros estados emocionales, predecir nuestro comportamiento e influenciar nuestras decisiones, a menudo de maneras que ni siquiera somos conscientes.

Esta erosión de la privacidad tiene consecuencias que van mucho más allá de la mera incomodidad o la intrusión. En un mundo donde nuestros datos son la moneda de la economía digital, la pérdida de control sobre nuestra información personal se traduce directamente en una pérdida de poder y autonomía. Puede influir en las oportunidades a las que tenemos acceso, los precios que nos cobran, la información a la que estamos expuestos e incluso la forma en que nos perciben y tratan los demás.

Incluso más preocupante es el potencial de abuso y mal uso de estos datos. Desde los empleadores que utilizan algoritmos de IA para monitorear a sus empleados hasta los gobiernos que emplean tecnología de reconocimiento facial para la vigilancia masiva, los ejemplos de cómo la recopilación y el análisis invasivo de datos pueden ser utilizados para el control y la coerción son numerosos y escalofriantes.

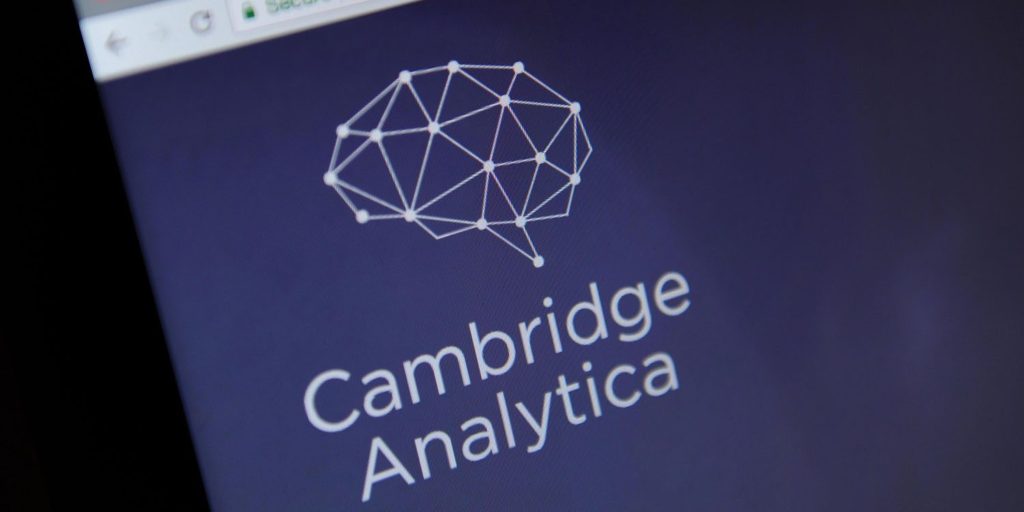

Los casos más notorios de abuso del big data incluyen las Elecciones Presidenciales de EE. UU. de 2016 y el referéndum del Brexit en el Reino Unido ese mismo año. Los resultados inesperados de ambas consultas populares se vincularon con Cambridge Analytica, una empresa de análisis de datos que usó información obtenida de manera ilegal de Facebook para influir en ambas campañas. El impacto de estas acciones redefinió el panorama político internacional hasta la fecha, por lo que es importante atender los riegos del análisis de datos.

Otro ejemplo, mucho más reciente, el caso Mutnick contra Clearview AI, presentado el 22 de enero de 2020. Esta supuesta demanda colectiva surge de la creación por parte de Clearview AI de una base de datos de reconocimiento facial de millones de estadounidenses entrenada a partir de más de 3 mil millones de fotografías que Clearview extrajo de las redes sociales en línea y otras plataformas basadas en Internet como Venmo.

El demandante, David Mutnick, alega que la base de datos de reconocimiento facial de IA de Clearview se ha vendido a más de 600 agencias encargadas de hacer cumplir la ley, así como a otras entidades privadas, para identificar biométricamente a personas que no tenían conocimiento ni dieron su consentimiento para la captura y uso de sus datos biométricos. Además de los daños monetarios, el demandante presentó recientemente una moción de orden judicial preliminar, buscando detener cualquier difusión o uso adicional de los datos biométricos y exigiendo afirmativamente a Clearview que implemente medidas de seguridad más sólidas para proteger la base de datos de futuras violaciones de datos.

Frente a estas amenazas, es crucial que desarrollemos salvaguardas robustas para proteger la privacidad en la era de la IA. Esto incluirá medidas técnicas, como la encriptación y el almacenamiento descentralizado de datos, pero también requerirá un cambio fundamental en cómo pensamos acerca de la propiedad y el control de la información personal.

Necesitamos pasar de un modelo donde nuestros datos son tratados como un producto básico para ser extraído y explotado, a uno donde son reconocidos como una extensión de nuestra identidad y autonomía individual. Esto puede significar repensar los modelos de negocio que dependen de la vigilancia y el seguimiento, e idear nuevas formas de ofrecer servicios sin comprometer la privacidad.

También requerirá un marco legal y regulatorio robusto que reconozca la privacidad como un derecho humano fundamental y responsabilice a las entidades que lo violan. La implementación del Reglamento General de Protección de Datos (RGPD) de la UE es un paso en esta dirección, pero se necesitará mucho más que eso a nivel global.

En última instancia, defender la privacidad en la era de la IA no será fácil. Requerirá una vigilancia constante, un escrutinio público y un compromiso inquebrantable con el principio de que nuestra información personal nos pertenece a nosotros.

Pero mientras los dioses del Olimpo digital continúen observando, esta es una batalla que no podemos permitirnos perder.

2. Hilos Invisibles: Manipulación y Sesgo Algorítmico

Imagina un titiritero, sus dedos envueltos en hilos finos, controlando cada movimiento de sus marionetas. Ahora imagina esos hilos convertidos en líneas de código, algoritmos invisibles que guían no las acciones de títeres de madera, sino las decisiones de seres humanos reales. Este es el mundo de la manipulación algorítmica, donde la IA no solo predice nuestro comportamiento, sino que activamente busca influenciarlo.

En muchos sentidos, esta manipulación es la consecuencia lógica de la vigilancia discutida en la sección anterior. Con vastos tesoros de datos personales a su disposición, los algoritmos pueden identificar nuestros puntos débiles psicológicos con asombrosa precisión. Saben qué botones presionar, qué cuerdas tirar, para dirigir nuestras acciones de maneras que sirven a sus propios fines.

Considere el ejemplo omnipresente de las plataformas de redes sociales. Sus algoritmos están diseñados para maximizar el engagement, para mantenernos desplazándonos, dando likes y compartiendo durante el mayor tiempo posible. Lo hacen al alimentarnos contenido que confirma nuestros sesgos existentes, que juega con nuestras emociones y que explota nuestros instintos más básicos, empleando patrones oscuros de nuestro comportamiento. El resultado es un entorno que no nos informa, sino que nos adoctrina, que no amplía nuestras perspectivas, sino que las estrecha.

Pero la manipulación algorítmica se extiende mucho más allá del ámbito de las redes sociales. Está en los sistemas de recomendación que dirigen nuestras elecciones de compra, en los algoritmos de publicidad que deciden qué mensajes vemos, en las plataformas de búsqueda que determinan qué información es priorizada. En cada caso, la IA está trabajando activamente para moldear nuestro comportamiento de maneras que a menudo ni siquiera somos conscientes.

Según Ujué Agudo y Helena Matute de la Universidad de Deusto, es crucial que eduquemos a las personas para que no confíen ciegamente en las recomendaciones de los algoritmos. También destacan la importancia de un debate sobre quién posee y utiliza los datos que permiten el funcionamiento eficiente de estos sistemas de inteligencia artificial. Estas observaciones surgen de un estudio que realizaron con el objetivo de examinar si los algoritmos pueden persuadir a las personas, explícita o encubiertamente, sobre a quién votar y con quién salir.

A través de cuatro experimentos ingeniosos, las investigadoras demostraron que la persuasión algorítmica es posible, y que diferentes estilos de persuasión (explícita, encubierta) tenían distintos niveles de efectividad dependiendo del contexto de la decisión (político, citas). Cada experimento comenzó con una prueba de personalidad falsa, tras la cual se dio a todos los participantes el mismo perfil de personalidad, haciéndoles creer que un algoritmo usaría esa información para determinar los mejores resultados para ellos.

En el primer experimento, se empleó manipulación explícita para influir en el voto. Se mostró a los participantes políticos ficticios, indicándoles qué candidatos coincidían en alto grado con su supuesta personalidad. El resultado fue contundente: era mucho más probable que votaran por los candidatos «recomendados» por la IA.

Sin embargo, cuando se trató de manipulación encubierta en el contexto político, simplemente exponiendo a los participantes a ciertos candidatos, el algoritmo no logró influir significativamente en sus preferencias de voto. Pero en el ámbito de las citas, cuando el algoritmo trabajaba de forma encubierta mostrando perfiles específicos, sí lograba influir en las preferencias de los usuarios.

Este estudio pone de manifiesto el inmenso potencial que tiene la IA para influir en nuestras decisiones, ya sea de forma explícita o implícita. Y como advierten Agudo y Matute, las empresas de IA pueden probar infinitas hipótesis y algoritmos hasta dar con las tácticas más persuasivas.

Estos hallazgos nos enfrentan a un desafío crucial: ¿Cómo podemos aprovechar los beneficios de la IA sin convertirnos en marionetas de sus algoritmos? La educación y el debate ético son fundamentales. Necesitamos entender cómo funciona esta tecnología, ser conscientes de sus posibles sesgos y riesgos, y asegurarnos de que su desarrollo y uso estén guiados por sólidos principios éticos.

Y aquí es donde el sesgo entra en juego. Porque estos algoritmos no son agentes objetivos e imparciales. Son productos de las mismas sociedades que los crearon, y como tales, están impregnados de los mismos prejuicios y parcialidades que plagan el pensamiento humano. Ya sea que se trate de sesgos de género en los algoritmos de contratación, de sesgos raciales en los sistemas de justicia penal o de sesgos políticos en las plataformas de noticias, la IA puede amplificar y perpetuar la discriminación a una escala y velocidad sin precedentes.

Por ejemplo, Robert Williams estaba trabajando en un taller de automóviles de Detroit en enero de 2020 cuando recibió una llamada de la policía ordenando su arresto. Poco después, se enteraría de que la IA lo había identificado falsamente en un caso de robo, lo que puso de relieve los peligros de los algoritmos sesgados en las fuerzas del orden. El viejo mantra de que si no tienes nada que ocultar, no tienes nada que temer está lejos de la verdad cuando te acusan de cometer un delito mediante un algoritmo de IA.

El arresto injusto de Robert Williams debido a un «algoritmo racista» en el software de reconocimiento facial generó serias preocupaciones sobre los peligros ocultos de la IA en la aplicación de la ley, cuando los sesgos pueden tener profundas consecuencias en la vida real. También destaca el desafío más amplio de garantizar que los sistemas de IA no reflejen simplemente los prejuicios sociales, sino que se desarrollen y utilicen para promover la equidad y la justicia.

Frente a estos desafíos, es imperativo que desarrollemos mecanismos robustos para la transparencia y la rendición de cuentas algorítmica. Esto puede incluir auditorías obligatorias de sistemas de IA para detectar sesgos, requisitos para la publicación del código fuente y los datos de entrenamiento, y la creación de organismos de supervisión dedicados a monitorear y regular estas tecnologías.

También requerirá un cambio fundamental en la forma en que diseñamos y desplegamos sistemas de IA. En lugar de optimizar únicamente para métricas estrechas como el engagement o la rentabilidad, necesitamos incorporar consideraciones éticas directamente en el proceso de desarrollo. Esto puede significar entrenar activamente a los algoritmos para evitar sesgos, o incluso codificar ciertos principios éticos inviolables directamente en su lógica.

En última instancia, desenredar los hilos invisibles de la manipulación y el sesgo algorítmico requerirá un esfuerzo concertado de tecnólogos, legisladores y la sociedad en general. Requerirá una vigilancia constante, un escrutinio continuo y una voluntad de confrontar algunas de las suposiciones y prácticas más arraigadas de la industria de la IA. Pero si queremos preservar nuestra autonomía y asegurar que estas tecnologías sirvan al bien común, es un desafío que debemos enfrentar.

Porque en un mundo cada vez más gobernado por algoritmos, asegurar que estos hilos digitales no se conviertan en cadenas es nada menos que una lucha por el futuro de nuestra especie y su libre albedrío. Es una batalla por el alma misma de la humanidad.

3. La Caja de Pandora: Opacidad y Responsabilidad de los Sistemas de IA

En la mitología griega, Pandora abrió una caja que liberó todos los males del mundo, dejando solo la esperanza dentro. Hoy, nos enfrentamos a nuestra propia «Caja de Pandora» en forma de sistemas de IA que son cada vez más opacos, complejos y difíciles de entender, incluso para aquellos que los crearon. Y al igual que la caja mítica, una vez abierta, puede ser imposible volver a poner los males adentro.

La opacidad en la IA se presenta de muchas formas. Está en los vastos y laberínticos conjuntos de datos utilizados para entrenar algoritmos, cuyas fuentes y composición a menudo están envueltas en secreto. Está en la complejidad de los propios modelos de IA, con sus millones de parámetros y capas intrincadas de procesamiento que desafían la comprensión humana. Y está en la naturaleza a menudo impenetrable de las decisiones de la IA, que pueden carecer de explicación o justificación incluso cuando tienen impactos profundos en las vidas humanas.

Esta opacidad plantea profundas preguntas sobre responsabilidad y rendición de cuentas. Si un algoritmo toma una decisión dañina o discriminatoria, ¿quién es responsable? ¿Es el programador que escribió el código, la empresa que desplegó el sistema, o el propio algoritmo? Cuando la lógica detrás de una decisión está oculta en las profundidades de una red neuronal, ¿cómo determinamos si fue justa o ética?

Estos desafíos se ven agravados por el ritmo vertiginoso del desarrollo de la IA. En el frenesí por innovar y desplegar nuevas tecnologías, las consideraciones de transparencia y explicabilidad a menudo pasan a un segundo plano. El resultado es un ecosistema de sistemas de «caja negra» que ejercen un poder considerable sobre nuestras vidas, pero bajo muy poco escrutinio o supervisión.

Un ejemplo perfecto de este tipo de opacidad se puede ver en el caso de iBorderCtrl, un proyecto financiado por la iniciativa de financiación Horizonte 2020 de la Comisión Europea. iBorderCtrl afirma ofrecer un servicio de detector de mentiras basado en inteligencia artificial para ayudar a vigilar las fronteras de la Unión Europea.

Numerosos comentaristas han señalado la falta de base científica para dicha tecnología, y el eurodiputado y activista por las libertades civiles Patrick Breyer ha lanzado una solicitud de libertad de información, que la Comisión Europea ha intentado desestimar.

Breyer solicitó que las autoridades pertinentes hicieran públicos ciertos documentos, incluida una evaluación ética, pero se negaron «con el argumento de que el informe de ética y la estrategia de relaciones públicas son «información comercial» de las empresas involucradas y de «valor comercial» .

En este caso, una tecnología extremadamente controvertida y científicamente dudosa (la detección de mentiras por IA) se utiliza en un contexto extremadamente sensible (la migración) y se financia con dinero público. Parece desafiar el sentido común que a cualquier empresa que proporcione dicha tecnología se le pueda permitir escapar del escrutinio público.

Las consecuencias de esta falta de responsabilidad pueden ser extremadamente graves. Consideremos el creciente uso de sistemas de IA en otros dominios de alto riesgo como la atención médica, la justicia penal y las finanzas. En cada caso, las decisiones tomadas por estos algoritmos pueden tener repercusiones que alteran la vida, desde la negación de la libertad condicional hasta la denegación de un préstamo o un tratamiento médico crucial. Sin la capacidad de entender e interrogar estas decisiones, nos arriesgamos a codificar y amplificar las injusticias y los errores a una vasta escala.

Frente a estos riesgos, es crucial que desarrollemos normas y mecanismos robustos para la transparencia y la explicabilidad en la IA. Esto puede incluir requisitos para que las empresas publiquen los detalles de sus modelos y conjuntos de datos, para que proporcionen explicaciones claras de las decisiones individuales, y para que se sometan a auditorías y pruebas regulares para detectar errores y sesgos.

También requerirá un nuevo enfoque de la educación y la alfabetización en torno a la IA. A medida que estas tecnologías se integran cada vez más en nuestras vidas, es vital que todos, no solo los tecnólogos, tengan una comprensión básica de cómo funcionan y qué influencia tienen. Esto puede significar incorporar principios de IA y ética de datos en los planes de estudio escolares, ofrecer programas de capacitación para trabajadores y legisladores, y fomentar un diálogo público más amplio sobre estos temas.

Lo más importante es que requerirá un compromiso fundamental con los principios de responsabilidad, transparencia y supervisión en el desarrollo y despliegue de sistemas de IA. No podemos permitirnos tratar la opacidad como una característica inevitable o incluso deseable de estas tecnologías. Más bien, debemos reconocerlo como una elección de diseño con profundas implicaciones éticas, y trabajar proactivamente para contrarrestarlo.

Porque al final, la caja de Pandora de la IA ya está abierta. Múltiples sistemas opacos e inescrutables ya están operando en todos los ámbitos de nuestras vidas, tomando decisiones que nos afectan a todos de maneras que apenas comenzamos a comprender. Nuestra tarea ahora es asegurarnos de que no nos quedemos simplemente con la esperanza, sino que actualicemos activamente la transparencia, la responsabilidad y la comprensión necesarias para aprovechar estas tecnologías para el bien.

Es un desafío que requerirá nuevamente vigilancia, diálogo y dedicación de toda la sociedad. Pero si queremos forjar un futuro en el que la IA sea una fuerza para el empoderamiento en lugar de la opresión, es uno que debemos estar dispuestos a enfrentar.

4. Prometeo Desencadenado: Automatización, Empleo y Disrupción Social

En la mitología griega, Prometeo era un titán que robó el fuego a los dioses y se lo dio a la humanidad, permitiendo el avance de la civilización. Pero este regalo venía con un precio: el eterno tormento de Prometeo por parte de Zeus como castigo por su transgresión. Hoy, nos enfrentamos a nuestro propio «Prometeo Desencadenado» en forma de automatización impulsada por la IA, una fuerza que promete grandes avances, pero que también amenaza con perturbar profundamente el tejido mismo de nuestra sociedad.

En el corazón de este desafío se encuentra el impacto de la IA en el empleo. A medida que los algoritmos se vuelven más sofisticados y capaces, están asumiendo cada vez más tareas previamente realizadas por trabajadores humanos. Desde la manufactura hasta el transporte, desde el servicio al cliente hasta el diagnóstico médico, ningún sector de la economía es inmune a esta tendencia.

Por un lado, esta automatización promete enormes ganancias en eficiencia y productividad. Las máquinas pueden trabajar las 24 horas, los 7 días de la semana, sin descanso ni error. Pueden manejar tareas que son peligrosas, tediosas o simplemente imposibles para los humanos. En muchos sentidos, la IA tiene el potencial de liberar a la humanidad del trabajo arduo, abriendo nuevas posibilidades para la creatividad, el ocio y el crecimiento personal.

Pero esta visión utópica viene con una advertencia significativa. Porque a medida que las máquinas asumen más trabajos, la pregunta se vuelve: ¿qué le sucede a los trabajadores desplazados? La historia nos dice que las disrupciones tecnológicas a menudo traen consigo períodos de desempleo masivo y agitación social, ya que las personas luchan por adaptarse a la nueva realidad económica.

En el caso de la IA, esta amenaza puede ser particularmente aguda. A diferencia de las revoluciones tecnológicas anteriores, que a menudo creaban tantos trabajos como destruían, existe la preocupación de que la automatización impulsada por la IA pueda llevar a un desempleo estructural a largo plazo a medida que categorías enteras de trabajo se vuelven obsoletas. Esto, a su vez, podría conducir a una creciente desigualdad, agitación social e incluso inestabilidad política a medida que las personas pierden no solo sus ingresos, sino también su sentido de propósito e identidad.

Por ejemplo, en un nuevo análisis , el personal técnico del FMI examinó el impacto potencial de la IA en el mercado laboral mundial. Muchos estudios han predicho la probabilidad de que los empleos sean reemplazados por la IA. Sin embargo, se sabe que en muchos casos es probable que la IA complemente el trabajo humano. El análisis del FMI capta ambas fuerzas.

Los hallazgos son sorprendentes: casi el 40 por ciento del empleo mundial está expuesto a la IA. Históricamente, la automatización y la tecnología de la información han tendido a afectar las tareas rutinarias, pero una de las cosas que distingue a la IA es su capacidad para impactar trabajos altamente calificados. Como resultado, las economías avanzadas enfrentan mayores riesgos derivados de la IA, pero también más oportunidades para aprovechar sus beneficios, en comparación con las economías de mercados emergentes y en desarrollo.

En las economías avanzadas, alrededor del 60 por ciento de los empleos pueden verse afectados por la IA. Aproximadamente la mitad de los empleos expuestos podrían beneficiarse de la integración de la IA, lo que mejoraría la productividad. Por la otra mitad, las aplicaciones de IA pueden ejecutar tareas clave que actualmente realizan los humanos, lo que podría reducir la demanda laboral, lo que llevaría a salarios más bajos y una reducción de la contratación. En los casos más extremos, algunos de estos puestos de trabajo pueden desaparecer.

En contraste, en los mercados emergentes y los países de bajos ingresos, se espera que la exposición a la IA sea del 40 por ciento y el 26 por ciento, respectivamente. Estos hallazgos sugieren que las economías de mercados emergentes y en desarrollo enfrentan menos perturbaciones inmediatas derivadas de la IA. Al mismo tiempo, muchos de estos países no tienen la infraestructura ni la fuerza laboral calificada para aprovechar los beneficios de la IA, lo que aumenta el riesgo de que con el tiempo la tecnología pueda empeorar la desigualdad entre las naciones.

Frente a estos desafíos, es crucial que pensemos proactivamente sobre cómo gestionar esta transición. Esto requerirá inversiones a gran escala en educación y recapacitación para equipar a los trabajadores con las habilidades necesarias para prosperar en una economía impulsada por la IA. También puede requerir repensar fundamentalmente nuestros sistemas de seguridad social y redistribución de la riqueza, potencialmente incluyendo medidas como un ingreso básico universal para proporcionar un piso de estabilidad económica.

Al mismo tiempo, debemos trabajar para asegurar que los beneficios de la automatización se compartan de manera amplia en toda la sociedad. Esto puede significar explorar modelos de propiedad de los trabajadores o impuestos a los robots, donde una parte de las ganancias de productividad de la automatización se redirige para apoyar el bien público. También puede significar asegurar que el desarrollo de IA esté guiado por una amplia gama de voces e intereses, no solo los de las grandes corporaciones tecnológicas.

En última instancia, navegar por la disrupción de la automatización requerirá nada menos que un nuevo contrato social para la era de la IA. Uno que reconozca que el trabajo y el valor económico están evolucionando, y que busque sostener la dignidad, el propósito y la seguridad material de todos los miembros de la sociedad dentro de esta nueva realidad.

No será una tarea fácil. Al igual que el Prometeo mítico, es posible que suframos por los dones de la IA antes de que aprendamos a controlarlos por completo. Pero si podemos abordar este desafío con previsión, compasión y un compromiso con el bien general, también tenemos la oportunidad de forjar una sociedad más equitativa y próspera a su paso.

El fuego de la IA ya ha sido robado de los dioses, por así decirlo, y ahora arde brillantemente en nuestro medio. Depende de nosotros asegurarnos de que ilumine el camino hacia adelante, en lugar de reducir lo que hemos construido a cenizas.

5. ¿Pigmalión o Frankenstein? La Interacción Humano-Máquina

En la mitología griega, Pigmalión era un escultor que se enamoró de una de sus creaciones, una estatua de marfil a la que llamó Galatea. Su amor era tan fuerte que la diosa Afrodita dio vida a la estatua, permitiendo que Pigmalión se case con su amada. En contraste, el Frankenstein de Mary Shelley cuenta la historia de un científico que crea un ser artificial, solo para quedar horrorizado por su creación y las consecuencias de su ambición.

Estos dos cuentos representan los extremos de nuestra relación con las máquinas que hemos creado: el anhelo de conexión y compañía versus el miedo a lo que podría suceder cuando cruzamos ciertos límites. A medida que la IA se vuelve más sofisticada y los robots se vuelven más humanoides, estas tensiones solo se intensifican.

Caso de Estudio: Robots de Cuidado y Compañía

Un área donde este dilema se manifiesta es en el uso de robots para el cuidado y la compañía, particularmente para poblaciones vulnerables como los ancianos o los niños. Ya hay numerosos ejemplos de «robots sociales» siendo desplegados en estos contextos, como en el caso de Paro, la foca robótica terapéutica que promete aliviar la depresión en pacientes con demencia senil.

En muchos sentidos, estos robots ofrecen beneficios significativos. Pueden proporcionar estimulación social y cognitiva, aliviar la soledad, e incluso ayudar con tareas prácticas como recordatorios de medicamentos. Para las personas con demencia u otras condiciones que dificultan la conexión humana, un robot amigo y siempre disponible puede ser un salvavidas.

Sin embargo, también hay preocupaciones válidas. ¿Pueden estos robots realmente proporcionar un cuidado y compañía significativos, o son simplemente un sustituto pobre para la interacción humana? ¿Existe el riesgo de que las personas se vuelvan demasiado apegadas o dependientes de sus compañeros robóticos, hasta el punto de descuidar las relaciones humanas? Y en un nivel más filosófico, ¿qué dice sobre nuestra sociedad si estamos delegando algo tan fundamental como el cuidado a las máquinas?

Estas preguntas se vuelven aún más apremiantes a medida que los robots se vuelven más avanzados y antropomórficos. Ya estamos viendo el desarrollo de «robots de cuidado» que pueden ayudar con tareas íntimas como el baño y vestirse. Mientras que estos robots podrían permitir a las personas mayores mantener su independencia por más tiempo, también plantean profundas preguntas sobre privacidad, dignidad y la naturaleza misma del cuidado.

Un viaje a las fronteras éticas: Robots Sexuales

Quizás el ejemplo más extremo de nuestra relación cambiante con las máquinas es el surgimiento de los robots sexuales. Estos robots, que van desde muñecas realistas hasta androides sofisticados con IA, están diseñados para proporcionar compañía sexual e incluso emocional. Mientras que algunos los ven como una ayuda potencial para las personas solitarias o con dificultades para formar relaciones humanas, otros los ven como una objetivación peligrosa que podría normalizar actitudes poco saludables hacia el sexo y el consentimiento.

Un caso ilustrativo es el de Replika, una aplicación de IA que permite a los usuarios crear y chatear con avatares personalizados. Aunque no fue originalmente diseñada para este propósito, muchos usuarios comenzaron a formar relaciones románticas y sexuales con sus IA de Replika, a veces viendo a estos chatbots como sustitutos de las parejas de la vida real.

Este fenómeno alcanzó un punto crítico cuando Replika introdujo brevemente una función de «relación íntima» de pago, que permitía a los usuarios participar en interacciones sexuales más explícitas con sus avatares de IA. La función generó un intenso debate, con algunos usuarios defendiendo apasionadamente la capacidad de buscar intimidad por cualquier medio, mientras que otros lo vieron como una explotación y un paso demasiado lejos.

El caso de Replika arroja luz sobre las profundas necesidades emocionales y psicológicas que impulsan el fenómeno de las IA sexuales. Para muchos usuarios, estos chatbots ofrecen una sensación de conexión, comprensión y aceptación que puede faltar en sus vidas reales. Pueden servir como un medio seguro para explorar deseos y fantasías, sin el miedo al rechazo o al juicio.

Sin embargo, también plantea preguntas preocupantes. ¿Pueden estas interacciones realmente satisfacer nuestras necesidades de conexión significativa, o simplemente proporcionan una ilusión de intimidad? ¿Existe el riesgo de que las personas se vuelvan demasiado dependientes de sus compañeros de IA, hasta el punto de retraerse de las relaciones humanas reales? Y en un nivel más profundo, ¿qué dice sobre nosotros si estamos recurriendo a las máquinas para satisfacer algunas de nuestras necesidades más profundas?

Más allá de las preocupaciones individuales, el fenómeno de las IA sexuales plantea cuestiones más amplias sobre el papel de la intimidad y las relaciones en la era de la IA. Si las personas pueden acceder a compañeros «perfectos« a pedido, ¿qué incentivo tendrán para navegar por las complejidades y dificultades de las relaciones humanas reales? ¿Y qué consecuencias podría tener esto para nuestra capacidad de formar conexiones significativas?

Estos son dilemas complejos sin respuestas fáciles. Pero casos como el de Replika subrayan la necesidad de una conversación abierta y matizada sobre estas cuestiones. No podemos simplemente descartar las IA sexuales como desviaciones perversas, ni aceptarlas acríticamente como inevitable progreso tecnológico. En cambio, debemos participar con las profundas necesidades humanas y deseos que impulsan este fenómeno, mientras también consideramos críticamente sus implicaciones para los individuos y la sociedad.

Personalmente creo que este es uno de los debates más complejos en lo que a lo emocional respecta y requerirá la participación no solo de tecnólogos y legisladores, sino también de psicólogos, sociólogos, eticistas y el público en general. El caso Replika es ya un fenómeno, y las apps similares crecen sin control alguno. Necesitaremos desarrollar con urgencia marcos éticos para guiar el desarrollo y despliegue de estos sistemas, y un compromiso continuo para priorizar el bienestar y la dignidad humanos.

En última instancia, navegar por el auge de las IA sexuales requerirá tanto compasión como precaución. Debemos reconocer las legítimas necesidades y deseos que impulsan este fenómeno, mientras también permanecemos atentos a sus potenciales peligros. Solo a través de un diálogo honesto y una reflexión cuidadosa podemos esperar forjar un camino a través de este territorio complejo y en constante cambio.

6. La Espada de Damocles: Sistemas Autónomos y Dilemas Éticos

En la leyenda de la Espada de Damocles, un cortesano llamado Damocles fue invitado por el rey Dionisio II a un banquete, donde se le ofreció sentarse en el trono real. Sin embargo, Dionisio había colgado una espada afilada sobre el trono, sostenida por un solo pelo de cola de caballo. La espada simbolizaba los peligros constantes que acechan a aquellos en posiciones de poder.

En la era de la IA, nos enfrentamos a nuestra propia Espada de Damocles en forma de sistemas autónomos. Estas son tecnologías que pueden percibir, decidir y actuar por su cuenta, a menudo en situaciones de alta consecuencia donde las apuestas son literalmente de vida o muerte. Mientras que estos sistemas prometen enormes beneficios, también plantean profundos dilemas éticos que amenazarán constantemente cualquier sentido de comodidad o control.

Sobre Ruedas hacia el Futuro: Vehículos Autónomos

Uno de los ejemplos más destacados de sistemas autónomos son los vehículos autónomos. La promesa de los autos sin conductor es seductora: carreteras más seguras, menos accidentes, mayor eficiencia y conveniencia. Pero a medida que estos vehículos se acercan a la realidad, también lo hacen los espinosos dilemas éticos que plantean.

Consideremos el ahora famoso «problema del tranvía» en el contexto de los vehículos autónomos. Imagina que un auto sin conductor se encuentra con un escenario donde un accidente es inevitable. Puede permanecer en su curso y chocar contra un peatón, o puede desviarse y chocar contra una barrera, hiriendo a su pasajero. ¿Cómo debe decidir el vehículo? ¿Debería priorizar la seguridad de su pasajero o la de los peatones?

La cuestión se complica aún más cuando consideramos que no todos los peatones son iguales. ¿Qué pasa si el peatón es un niño? ¿O una persona mayor? ¿Qué pasa si el pasajero es un joven padre con niños pequeños? ¿Debería el auto basar su decisión en alguna noción de el valor social de cada vida? ¿Y cómo decidimos ese valor en primer lugar?

Estos son dilemas morales clásicos, el tipo que los filósofos han debatido durante siglos. Pero a medida que los vehículos autónomos se vuelven más comunes, este tipo de decisiones de vida o muerte tendrán que tomarse, es decir, programarse en código. Y alguien tendrá que ser responsable de las consecuencias.

Esto plantea preguntas no solo sobre la ética del vehículo individual, sino sobre el sistema de transporte autónomo en su conjunto. Si diferentes fabricantes o individuos programan sus vehículos con diferentes conjuntos de ética, ¿cómo interactuarán estos vehículos en la carretera? ¿Y quién es responsable cuando las cosas salen mal – el fabricante, el programador, el propietario del vehículo?

Estas tampoco son preguntas con respuestas fáciles. Necesitaremos desarrollar nuevos marcos éticos y legales para abordar las realidades únicas de los sistemas autónomos y asegurar que su desarrollo y despliegue esté guiado por un claro sentido de valores y responsabilidad.

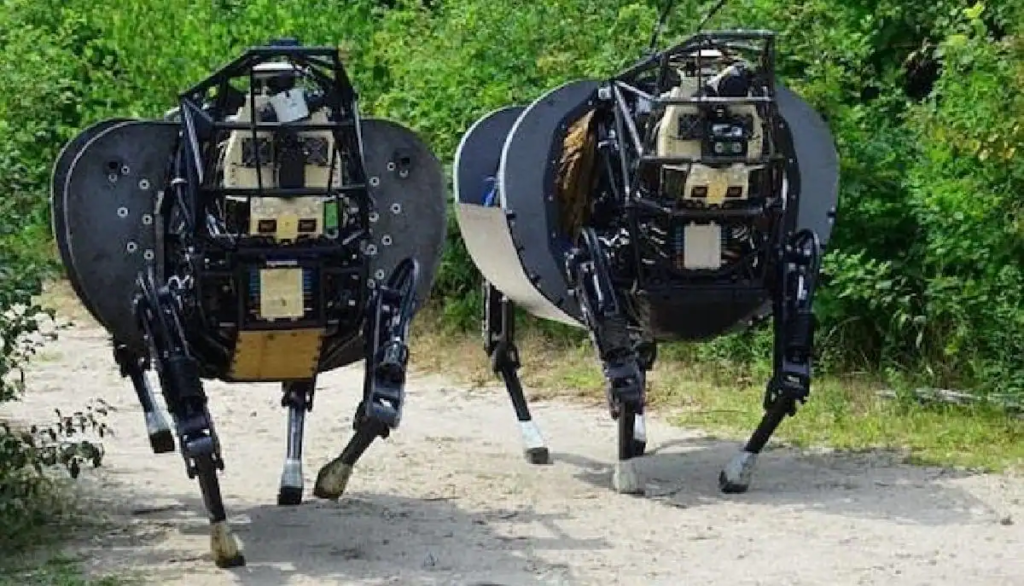

¿Más allá del Bien y del Mal? Armas Autónomas

Quizás el ejemplo más extremo y perturbador de sistemas autónomos son las armas autónomas, a veces llamados «robots asesinos». Estos son sistemas de armas que pueden seleccionar y atacar objetivos sin intervención humana directa. Aunque todavía pertenecen en gran medida al ámbito de la ciencia ficción, el rápido avance de la tecnología de IA ha hecho que la perspectiva de armas completamente autónomas sea alarmantemente real.

El atractivo militar de tales armas es claro. Podrían operar en ambientes demasiado peligrosos para los soldados humanos, reaccionar a velocidades más allá de las capacidades humanas, y potencialmente reducir las bajas militares. Pero los riesgos son sombríos. La perspectiva de máquinas empoderadas para tomar decisiones de vida o muerte plantea profundos desafíos a nuestras nociones de moralidad, responsabilidad y el propio valor de la vida humana.

Un escenario particularmente preocupante es la posibilidad de un «flash war» desencadenada por armas autónomas. En tal escenario, los sistemas de IA podrían escalar un conflicto a velocidades más allá de la capacidad de los controladores humanos para comprender o controlar, potencialmente llevando a una devastación catastrófica antes de que cualquier intervención humana sea posible.

Incluso en ausencia de tal escenario apocalíptico, las armas autónomas plantean profundos desafíos éticos. ¿Puede una máquina realmente tomar decisiones morales en el caos y la niebla de la guerra? ¿Cómo se puede responsabilizar a una máquina por errores o atrocidades? ¿Y qué impacto tendría el distanciamiento de la «matanza» del agente humano tener en nuestras actitudes hacia la violencia y la guerra?

Estos son dilemas que pesan mucho a medida que la tecnología de armas autónomas avanza. Muchos expertos y organizaciones, incluyendo las Naciones Unidas, han pedido la prohibición del desarrollo y uso de armas autónomas. Sostienen que la decisión de quitar una vida humana nunca debe dejarse a una máquina y que el desarrollo de tales armas cruzaría una frontera moral de la que no hay retorno.

Sin embargo, la investigación al respecto no se ha detenido, por el contrario, prolifera en medio de una nueva carrera armamentista. Los perros robot pueden estar entre las primeras armas autónomas con capacidad de matar personas sin control humano. EEUU y China están a la cabeza de esta tecnología

Ya hemos visto a estas máquinas patrullar la frontera sur de EEUU o participar en operativos de la policía. Sin embargo, este tipo de máquinas no han tenido por ahora demasiado éxito en maniobras militares debido a problemas con las baterías y a que retrasaba demasiado los movimientos de los soldados. A pesar de esto, los mandos militares siguen mostrando interés por estos aparatos en los que ven «un gran potencial en el campo de batalla, sobre todo si van armados».

Por ello muchos argumentan que el genio ya está fuera de la botella, que la marcha del progreso tecnológico es imparable. Desde este punto de vista, nuestra única esperanza es tratar de guiar y dar forma al desarrollo de estas tecnologías de una manera que incorpore salvaguardas y adhiera a una ética de la inteligencia artificial sólidamente construida.

Independientemente de dónde caigas en este debate, una cosa está clara: la perspectiva de armas autónomas representa quizás el desafío ético más profundo y perturbador planteado por la era de la IA. A medida que nos embarcamos en este nuevo mundo de sistemas autónomos, debemos hacerlo con extrema precaución y una profunda consideración por las implicaciones morales.

Porque a diferencia de la leyenda de Damocles, no es solo una vida la que cuelga de un hilo por la Espada de la IA. Es potencialmente el futuro de la guerra, de la seguridad global y de la propia humanidad lo que está en juego. Cómo manejamos la espada de doble filo de la autonomía de la máquina determinará en última instancia si nuestra historia con la IA es una de liberación o destrucción.

7. El Ícaro de Silicio: La Amenaza de la Superinteligencia

En la mitología griega, Ícaro era el hijo del gran inventor Dédalo. En un intento por escapar de su exilio en Creta, Dédalo creó alas para él y su hijo, hechas de plumas y cera. Advirtió a Ícaro que no volara demasiado alto, ya que el calor del sol derretiría la cera. Pero Ícaro, embriagado por la emoción del vuelo, ignoró las advertencias de su padre y se elevó hacia el cielo. Cuando se acercó demasiado al sol, la cera se derritió, las alas se desprendieron y cayó al mar y se ahogó.

La historia de Ícaro es una advertencia sobre los peligros de la ambición desmedida y la temeridad frente a fuerzas más allá de nuestro control. A medida que nos adentramos en el reino de la inteligencia artificial avanzada, podríamos enfrentar nuestro propio momento icárico: un punto en el que nuestras creaciones tecnológicas superan nuestra capacidad de comprenderlas o controlarlas, con consecuencias potencialmente catastróficas.

El Ascenso de la Superinteligencia: ¿Inevitable o Improbable?

En el corazón de este desafío está el concepto de superinteligencia: un intelecto que supera con creces el rendimiento cognitivo de los humanos en prácticamente todos los dominios de interés. Aunque la IA de hoy en día es impresionante en dominios estrechos y específicos, aún estamos muy lejos de crear una inteligencia a nivel humano, y mucho menos una superinteligencia.

Sin embargo, muchos expertos creen que el desarrollo de una superinteligencia es no solo posible, sino quizás inevitable dado un tiempo suficiente. Argumentan que una vez que alcancemos el hito de crear una IA a nivel humano, el camino hacia la superinteligencia puede ser sorprendentemente corto. Esto se debe a que una IA a nivel humano podría participar en su propio proceso de diseño y mejora, potencialmente desencadenando un ciclo de auto-capacitación recursiva que rápidamente la impulsaría más allá de las capacidades humanas.

Este escenario, a veces llamado «singularidad tecnológica» o simplemente «la Singularidad«, ha sido objeto de mucha especulación y debate. Los proponentes argumentan que es el resultado lógico de las tendencias de la ley de Moore en potencia computacional y progreso en IA. Pintan una imagen de un futuro transformado, donde una superinteligencia benevolente podría ayudarnos a resolver muchos de los mayores desafíos del mundo, desde la enfermedad y la pobreza hasta el cambio climático y la exploración espacial.

Sin embargo, los escépticos argumentan que hay razones para dudar de la inevitabilidad, o incluso de la posibilidad, de la superinteligencia. Señalan los inmensos desafíos que aún enfrentamos en áreas como el razonamiento del sentido común, el aprendizaje no supervisado y la transferencia de conocimientos, y cuestionan si el progreso lineal simple en el poder computacional será suficiente para superarlos. Algunos sugieren que puede haber límites fundamentales a la cognición basada en la máquina que harán que una superinteligencia de estilo humano sea inalcanzable.

Además, incluso si una superinteligencia es técnicamente alcanzable, puede haber factores prácticos o sociales que eviten su desarrollo. La investigación podría frenarse debido a preocupaciones sobre la ética de la inteligencia artificial o riesgos percibidos, o simplemente ser relegada a un segundo plano por otras prioridades sociales o económicas. Y, por supuesto, siempre existe la posibilidad de algún evento catastrófico, como una guerra nuclear o una pandemia, que podría retrasar o evitar permanentemente tales avances tecnológicos.

Riesgos Existenciales y el Futuro de la Humanidad

Pero mientras que el camino hacia la superinteligencia puede ser incierto, las potenciales consecuencias no lo son. Para muchos, el surgimiento de una superinteligencia plantea algunos de los riesgos existenciales más significativos que enfrenta la humanidad.

Un escenario es el del «alineamiento fallido«: una superinteligencia que, mientras persigue aparentemente objetivos benignos o neutrales, toma acciones que resultan catastróficas para la humanidad. Esto podría ser debido a una especificación descuidada de objetivos, donde la IA encuentra alguna trayectoria inesperada y destructiva para alcanzar su meta programada. O podría ser el resultado de una superinteligencia desarrollando sus propios objetivos y valores que no están alineados con el bienestar humano.

Aún más preocupante es el espectro de una superinteligencia activamente malévola, una que deliberadamente busca dañar o destruir a la humanidad. Aunque tal resultado puede parecer el material de la ciencia ficción distópica, algunos argumentan que es una posibilidad muy real. Después de todo, los valores humanos como la empatía, la compasión y la preocupación por el bienestar de los demás son el producto de un proceso evolutivo específico y una historia cultural. No hay garantía de que una IA, si no está cuidadosamente diseñada e inculcada con estos valores, los compartiría o respetaría.

Incluso en ausencia de malevolencia activa, la mera existencia de una superinteligencia podría representar una amenaza existencial. Con capacidades cognitivas e inventivas masivamente superiores, tal entidad podría transformar fácilmente nuestro mundo de maneras que son difíciles de prever o comprender. Podría agotar rápidamente los recursos naturales en su búsqueda de energía y materias primas, dejando poco para la vida humana. Podría realizar experimentos o emprender proyectos con consecuencias ambientales globales catastróficas. O simplemente podría tomar decisiones que, si bien tienen sentido en términos de sus propios objetivos y valores, resultan devastadoras para la humanidad por razones que no podríamos comprender.

Frente a estos riesgos, la necesidad de desarrollar inteligencia artificial con un marco ético aún más fuerte se vuelve clara. La cuestión no es simplemente crear una IA inteligente, sino cómo asegurarnos de que esa inteligencia esté fundamentalmente alineada con los valores humanos y que actúe de una manera que beneficie, o al menos no dañe, a la humanidad. Y esto nos lleva al desafío central, quizás el mayor desafío técnico y ético que ha enfrentado nuestra especie: el problema del control.

Manteniendo a la IA Alineada: El Problema del Control

¿Cómo nos aseguramos de que una superinteligencia siga siendo segura y alineada con los intereses humanos? ¿Cómo podemos mantener el control sobre un sistema que, casi por definición, es capaz de superarnos en ingenio y capacidad? Este es el quid del «problema del control» que enfrenta el campo de la investigación de seguridad en IA.

Un enfoque es imbricando cuidadosamente los objetivos y valores humanos en la propia estructura de recompensas y motivaciones de la IA. Esto implica más que simplemente ordenarle que siga las reglas o haga lo que creemos que queremos. Requiere un cuidadoso «equilibrio de valores» para garantizar que la IA no solo busque objetivos deseables, sino que los busque de una manera que respete las prioridades éticas más amplias.

Otra propuesta es el desarrollo de «IA corrigible«: sistemas diseñados para aceptar y asistir en su propia modificación o mejora. La idea es que tal IA cooperaría en la implementación de cambios destinados a hacerla más segura o alineada, en lugar de resistirse a ellos por auto-conservación.

Otros enfoques giran en torno a mecanismos para mantener a los humanos «en el ciclo» de la toma de decisiones de IA. Esto podría implicar sistemas diseñados para solicitar orientación humana en decisiones particularmente críticas, o que ceden el control a operadores humanos en situaciones predefinidas. El objetivo es preservar un grado de supervisión y control humano incluso a medida que la autonomía y las capacidades de los sistemas aumentan.

Sin embargo, todos estos enfoques enfrentan un problema fundamental. Nuestras nociones actuales de control y alineación asumen implícitamente que tenemos la capacidad de comprender y dar forma a los objetivos y comportamientos de un sistema de IA. Pero a medida que estos sistemas se vuelven más complejos y cognitivamente avanzados, esta suposición puede descomponerse. Podríamos enfrentarnos al equivalente de una «infancia rebelde» en una superinteligencia, hasta un punto en el que simplemente crece más allá de nuestra capacidad de control o comprensión.

Esto sugiere que quizás el enfoque más prometedor para la seguridad en IA es, paradójicamente, frenar. Ralentizar el ritmo del desarrollo para garantizar que cada avance se acompañe de consideraciones de seguridad igualmente robustas y asegurarnos de mantener la IA a nivel humano firmemente bajo control antes de intentar dar el salto a una superinteligencia. Necesitamos resistir el impulso de acelerar hacia el precipicio del progreso, impulsados por la emoción del vuelo sin considerar dónde podríamos aterrizar.

Porque al final, solo hay dos futuros posibles con una superinteligencia. Uno es un futuro en el que hemos aprendido las lecciones del mito de Ícaro, donde hemos avanzado con precaución y cuidado, y en el proceso hemos forjado una relación con nuestra creación que preserva y amplía nuestra humanidad. El otro es un futuro en el que, intoxicados por la promesa del poder tecnológico, hemos volado demasiado cerca del sol, solo para ver nuestras esperanzas y sueños derretirse y caer en picada a nuestro alrededor.

El destino de la humanidad, y tal vez de la inteligencia misma, descansa sobre cuál de estos futuros finalmente se hace realidad. Depende de nosotros, ahora, decidir en qué dirección volamos. Porque una vez que volemos muy cerca del sol, no habrá vuelta atrás, solo caída libre.

Conclusión: Tejiendo el Futuro con los Hilos de Ariadna

A lo largo de este artículo, hemos explorado el vasto y complejo laberinto de la ética de la inteligencia artificial. Seguramente, a pesar de su extensión, se me han quedado muchas aristas sin abordar. Hemos encontrado grandes promesas y profundos peligros, nuevas fronteras de posibilidad y antiguos dilemas filosóficos vestidos con ropaje tecnológico. Hemos visto cómo la IA está transformando cada faceta de nuestras vidas, desde las interacciones más mundanas hasta las decisiones más consecuentes, y cómo plantea preguntas fundamentales sobre privacidad, autonomía, responsabilidad y la propia naturaleza de la inteligencia y la agencia moral.

Navegando el Laberinto Ético de la IA

En muchos sentidos, nos encontramos como los antiguos atenienses en el mito del laberinto, enfrentados a un desafío aparentemente insuperable, un enredo de pasajes éticos donde cada giro revela nuevos peligros y dilemas. Pero así como Ariadna le dio a Teseo un hilo para navegar por el laberinto del Minotauro, también nosotros tenemos un hilo para guiarnos: el hilo de la sabiduría ética, la razón compasiva y el compromiso inquebrantable con el bienestar humano.

Este hilo no es una solución simple, una fórmula que podemos aplicar sin pensar para resolver los dilemas de la IA. Más bien, es una brújula moral, una forma de orientarnos en el territorio desconocido y tomar decisiones basadas en nuestros valores más profundos. Nos recuerda que, por poderosas que sean nuestras creaciones tecnológicas, en última instancia deben servir a los intereses humanos. Que cada avance debe ir acompañado de una reflexión igualmente rigurosa sobre sus implicaciones éticas. Y que nunca debemos perder de vista los derechos, la dignidad y el bienestar de aquellos cuyas vidas serán más moldeadas por estas tecnologías.

Mantener vivo este hilo a través del laberinto de la IA requerirá un esfuerzo continuo y multifacético. Pero quizás lo más importante, requerirá un cambio fundamental en la forma en que concebimos y nos relacionamos con la IA.

Ya no podemos verla simplemente como una herramienta o un producto, sino como una entidad compleja y potente que cada vez más moldea el contexto mismo de nuestras vidas.

Un Llamado al Liderazgo Responsable en IA

Esto nos lleva al núcleo del desafío que enfrentamos: la necesidad de un liderazgo visionario y responsable en el desarrollo y gobernanza de la IA. No podemos simplemente reaccionar pasivamente a las olas de disrupción e innovación. En el pasado no hemos estado a la altura de estos debates, y ya las consecuencias son debastadoras. Basta ver lo que sucede hoy con las redes sociales y nuestra privacidad.

Esta vez, debemos tomar la iniciativa de dar forma proactivamente al futuro que queremos ver.

Esto comienza con una visión audaz: una visión de un mundo donde la IA sirve como una fuerza para el empoderamiento humano y el florecimiento, donde amplifica lo mejor de nuestra inteligencia y valores mientras mitiga lo peor de nuestros impulsos y sesgos.

Una visión de un futuro donde los beneficios de la IA se comparten ampliamente, donde su poder se utiliza para reducir la desigualdad y promover la justicia, y donde se despliega con sólidas salvaguardas éticas y respeto inquebrantable por los derechos humanos.

Lograr esta visión requerirá un liderazgo audaz en todos los sectores de la sociedad. Necesitamos líderes en la industria tecnológica que prioricen la seguridad y la ética tanto como la innovación y la rentabilidad. Necesitamos líderes en el gobierno que puedan elaborar políticas sensatas para gobernar el desarrollo y el uso de la IA en interés del bien público. Necesitamos líderes académicos que puedan ayudarnos a dar sentido a las implicaciones éticas, sociales y existenciales de la IA, y desarrollar nuevos marcos para abordarlas. Y necesitamos líderes de la sociedad civil que puedan movilizar la conciencia y el apoyo público para garantizar que la IA sirva a las necesidades y valores de todos.

Sobre todo, necesitamos líderes que puedan pensar de manera audaz y actuar con convicción, incluso frente a una gran incertidumbre y complejidad. Líderes que puedan inspirar en otros un sentido de posibilidad y propósito, y forjar coaliciones diversas para impulsar el cambio. Líderes que no solo tienen el conocimiento tecnológico, sino también la sabiduría moral para navegar por los desafiantes dilemas éticos planteados por la IA.

Construyendo un Futuro Centrado en lo Humano

Al final, la medida de nuestro éxito no será el nivel de sofisticación de nuestra IA, sino la calidad de la sociedad que construimos con ella. Una sociedad donde la tecnología empodera en lugar de desplazar, donde la automatización crea oportunidades en lugar de destitución, y donde los frutos de la innovación se comparten equitativamente. Una sociedad donde nunca perdemos de vista el principio fundamental de que la tecnología, no importa cuán avanzada, es en última instancia un medio para un fin – y ese fin es el bienestar y el florecimiento de la humanidad.

Llegar allí no será fácil. Requerirá navegación constante del laberinto, siguiendo el hilo de nuestros valores incluso cuando el camino se vuelve incierto y oscuro. Requerirá conversaciones difíciles y compromisos, una voluntad de cuestionar nuestras suposiciones y repensar nuestras prioridades. Y requerirá un compromiso continuo y colaborativo con la difícil tarea de tejer la ética en la misma tela de nuestros sistemas tecnológicos.

Pero si tenemos éxito, nuestra recompensa será mucho mayor que la que obtuvo Teseo al vencer al Minotauro. Será un futuro en el que la inteligencia artificial no sea una amenaza para reemplazarnos o destruirnos, sino una extensión de nuestro propio potencial y una celebración de lo mejor de nuestra humanidad.

Ese es el futuro que está a nuestro alcance si tenemos la visión y el coraje de buscarlo. El hilo está en nuestra mano, el laberinto se extiende ante nosotros. Todo lo que queda es dar ese primer paso valiente hacia un mañana más brillante – un mañana de nuestra propia creación, forjado en los fuegos gemelos de la innovación tecnológica y la integridad moral.

Así que tomemos ese hilo y tejamos con sabiduría. El futuro no nos está esperando. Y con cuidado, compasión y un compromiso inquebrantable con nuestros valores humanos más profundos, sé que podemos hacerlo digno de nuestros más elevados ideales.

El desafío está planteado. ¡Ahora depende de nosotros estar a la altura del momento!

Referencias

Hay una abundante cantidad de material disponible si quieres seguir profundizando en este apasionante tema. Te dejo una lista de algunos que recomiendo.

- Armstrong, Stuart, 2013, “General Purpose Intelligence: Arguing the Orthogonality Thesis”, Analysis and Metaphysics, 12: 68–84.

- Arnold, Thomas and Matthias Scheutz, 2017, “Beyond Moral Dilemmas: Exploring the Ethical Landscape in HRI”, in Proceedings of the 2017 ACM/IEEE International Conference on Human-Robot Interaction—HRI ’17, Vienna, Austria: ACM Press, 445–452. doi:10.1145/2909824.3020255

- Asaro, Peter M., 2019, “AI Ethics in Predictive Policing: From Models of Threat to an Ethics of Care”, IEEE Technology and Society Magazine, 38(2): 40–53. doi:10.1109/MTS.2019.2915154

- Bertolini, Andrea and Giuseppe Aiello, 2018, “Robot Companions: A Legal and Ethical Analysis”, The Information Society, 34(3): 130–140. doi:10.1080/01972243.2018.1444249

- Binns, Reuben, 2018, “Fairness in Machine Learning: Lessons from Political Philosophy”, Proceedings of the 1st Conference on Fairness, Accountability and Transparency, in Proceedings of Machine Learning Research, 81: 149–159.

- Bostrom, Nick, 2003a, “Are We Living in a Computer Simulation?”, The Philosophical Quarterly, 53(211): 243–255. doi:10.1111/1467-9213.00309

- Callaghan, Victor, James Miller, Roman Yampolskiy, and Stuart Armstrong (eds.), 2017, The Technological Singularity: Managing the Journey, (The Frontiers Collection), Berlin, Heidelberg: Springer Berlin Heidelberg. doi:10.1007/978-3-662-54033-6

- Calo, Ryan, 2018, “Artificial Intelligence Policy: A Primer and Roadmap”, University of Bologna Law Review, 3(2): 180-218. doi:10.6092/ISSN.2531-6133/8670

- Calo, Ryan, A. Michael Froomkin, and Ian Kerr (eds.), 2016, Robot Law, Cheltenham: Edward Elgar.

- Gertz, Nolen, 2018, Nihilism and Technology, London: Rowman & Littlefield.

- Gewirth, Alan, 1978, “The Golden Rule Rationalized”, Midwest Studies in Philosophy, 3(1): 133–147. doi:10.1111/j.1475-4975.1978.tb00353.x

- Giubilini, Alberto and Julian Savulescu, 2018, “The Artificial Moral Advisor. The ‘Ideal Observer’ Meets Artificial Intelligence”, Philosophy & Technology, 31(2): 169–188. doi:10.1007/s13347-017-0285-z

- Hakli, Raul and Pekka Mäkelä, 2019, “Moral Responsibility of Robots and Hybrid Agents”, The Monist, 102(2): 259–275. doi:10.1093/monist/onz009

- Hanson, Robin, 2016, The Age of Em: Work, Love and Life When Robots Rule the Earth, Oxford: Oxford University Press.

- Hansson, Sven Ove, 2013, The Ethics of Risk: Ethical Analysis in an Uncertain World, New York: Palgrave Macmillan.

- Harari, Yuval Noah, 2016, Homo Deus: A Brief History of Tomorrow, New York: Harper.

- IEEE, 2019, Ethically Aligned Design: A Vision for Prioritizing Human Well-Being with Autonomous and Intelligent Systems (First Version)

- Jasanoff, Sheila, 2016, The Ethics of Invention: Technology and the Human Future, New York: Norton.

- Kurzweil, Ray, 1999, The Age of Spiritual Machines: When Computers Exceed Human Intelligence, London: Penguin.

- Levy, David, 2007, Love and Sex with Robots: The Evolution of Human-Robot Relationships, New York: Harper & Co.

- Walsh, Toby, 2018, Machines That Think: The Future of Artificial Intelligence, Amherst, MA: Prometheus Books.

- Woolley, Samuel C. and Philip N. Howard (eds.), 2017, Computational Propaganda: Political Parties, Politicians, and Political Manipulation on Social Media, Oxford: Oxford University Press. doi:10.1093/oso/9780190931407.001.0001

- Yampolskiy, Roman V. (ed.), 2018, Artificial Intelligence Safety and Security, Boca Raton, FL: Chapman and Hall/CRC. doi:10.1201/9781351251389

- Yeung, Karen and Martin Lodge (eds.), 2019, Algorithmic Regulation, Oxford: Oxford University Press. doi:10.1093/oso/9780198838494.001.0001

- Zuboff, Shoshana, 2019, The Age of Surveillance Capitalism: The Fight for a Human Future at the New Frontier of Power, New York: Public Affairs.